蚂蚁集团重磅推出LingBot-VLA视觉-语言-动作基础模型,同步开源全套代码库与工具链,深度聚焦现实场景中的机器人复杂操控任务,为具身智能领域带来关键突破,正式宣告双臂机器人操控迈入大模型驱动的全新阶段。

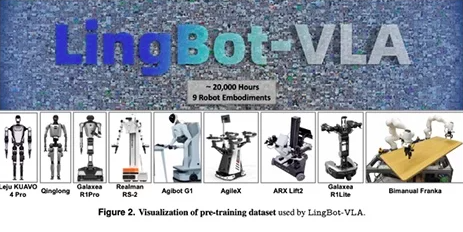

该模型依托20000小时海量真实机器人操作数据训练,覆盖9种主流双臂机器人构型,成功打破不同机器人的形态壁垒,可赋予各类双臂机器人通用操控能力,无需重复采集数据微调即可快速适配不同硬件。其融合深度感知技术,在真机与仿真测试中表现优异,操控成功率显著优于同类模型。

LingBot-VLA不仅提升了机器人双臂协同的精准度与鲁棒性,还大幅降低了模型训练与落地成本,已与多家机器人厂商完成适配,为双臂机器人规模化商用奠定基础,推动具身智能技术向可复用、可规模化方向迈进。

.

.

.

.

.

.