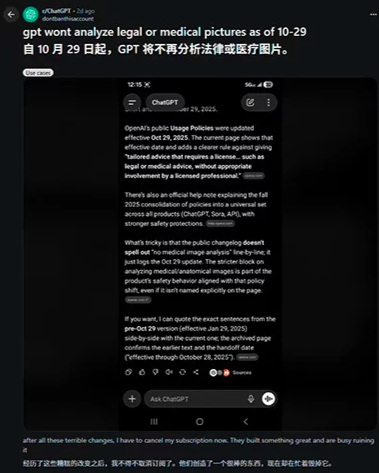

2025 年 10 月 29 日,OpenAI 悄然更新《使用政策》,明确禁止 ChatGPT 及旗下所有 AI 模型提供医疗、法律和财务领域的专业建议。这一调整并非偶然,而是对全球 AI 监管浪潮的直接回应 —— 既要契合欧盟《人工智能法案》对高风险 AI 系统的严格规范,也要符合美国食品药品监督管理局(FDA)关于临床决策支持软件的监管要求。

此次政策收紧覆盖的范围远超初期猜测。最初,Reddit 用户发现上传医学影像请求分析时被模型拒绝,这一细节揭开了新规的面纱。事实上,禁令已延伸至专业服务的核心场景:医疗领域不再解读影像、协助诊断;法律领域拒绝起草合同、解读具体案件条款;财务领域则停售证券推荐、税务策略设计等定制化建议。

值得注意的是,ChatGPT 并非完全退出这些领域,而是划定了清晰的服务边界。模型会明确告知用户:“可以一般性解释法律法规、经济趋势等基础概念,但无法就个人案件、具体投资给出建议”。这种 “能解释原理,不代做判断” 的定位,本质是将 AI 从 “专业决策者” 拉回 “信息辅助者” 的角色,同时引导用户转向人类专家咨询。

政策调整背后,是监管压力与技术风险的双重驱动。欧盟《人工智能法案》将医疗诊断、金融决策等纳入高风险 AI 范畴,要求此类系统必须经过严格认证、留存可追溯日志且接受人工监督,违规企业最高可面临全球营收 7% 的罚款。而过往案例更凸显了风险的紧迫性:摩洛哥男子因 ChatGPT 误判痔疮实施自疗导致急诊,瑞士心脏病人因模型建议延误治疗引发中风,这些事件让 OpenAI 不得不主动规避责任风险。

对普通用户而言,新规意味着失去了一条低成本获取专业信息的捷径。此前,许多人依赖 ChatGPT 快速梳理法律权益、参考健康建议或了解投资逻辑,以避开专业服务的高昂费用。但对医生、律师等从业者而言,这相当于多了一道 “职业防护盾”,减少了 AI 误判对行业信任的冲击。

值得关注的是,新规并未禁止专业人士使用 AI 增强服务能力。业内推测,这可能指向 “ChatGPT 医疗版”“法律版” 等垂直产品的研发方向 —— 通过资质验证向持证者开放高级功能,实现专业需求与监管合规的平衡。这种 “普通版限流、专业版升级” 的思路,或许将成为大型 AI 模型应对监管的通用策略。

.

.

.

.

.

.

.